当今数字世界,无论是流程优化,还是商业模式的创新,都离不开对数据的高效利用,而成倍增加的数据使得强大的计算能力成为了关键,无论是互联网行业还是传统行业,都需要用更加智能且高速的基础架构来支撑业务转型、加速数字化进程。

作为数字化时代的基础设施,数据中心的重要性毋庸置疑,但现如今不断演进的数据中心越来越需要一个全新的智能架构。这一架构内,大规模分布式异构计算能够协同工作,无缝连接,形成一个独立的计算平台。这种新架构将有助于解决当今资源搁浅、数据流拥堵和平台安全不兼容的挑战。

正如英特尔CEO帕特·基辛格在5月10日的英特尔On产业创新峰会上所说的那样,全球市场正处于*具活力的时代。企业目前面临的挑战错综复杂且相互关联,而成功的关键取决于企业快速采用和*大化利用领先技术和基础设施的能力。

而现在看来,英特尔正在运用其规模、资源、芯片、软件及服务全方位的能力,为未来的数据中心赋能。

千呼万唤始出来,Sapphire Rapids宣布出货

在活动当天,英特尔宣布已出货代号为Sapphire Rapids的第四代英特尔至强可扩展处理器的初始SKU,预计在今年还会有更多出货。

Sapphire Rapids基于Intel 7制程工艺技术,采用英特尔性能核与全新加速器引擎,被称作树立了下一代数据中心处理器的标准。Sapphire Rapids的核心是一个分区块、模块化的SoC架构,采用英特尔的嵌入式多芯片互连桥接(EMIB)封装技术,支持加速器接口架构指令集、高级矩阵扩展,以及数据流加速器,能够提供更高的整体工作负载性能,在CPU、内存和缓存以及所有附加的内存、存储和网络设备之间移动数据。当然作为面向数据中心的新一代处理器,Sapphire Rapids通过先进的内存和下一代I/O,包括PCIe5.0、CXL1.1、DDR5和HBM技术,来推动行业技术转型。

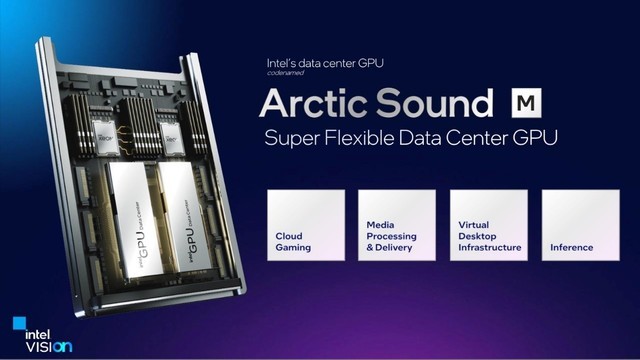

面向数据中心负载的Arctic Sound-M GPU

随着当前工作负载密度和复杂程度的快速增长,云游戏、多媒体处理与传输、虚拟桌面基础架构和推理运算也提出了不同的负载需求,基于此,英特尔正式推出了代号为Arctic Sound-M(ATS-M)的数据中心GPU,ATS-M是一颗支持高质量转码和高性能的强大GPU,能够提供每秒150万亿次运算(150 TOPS),共拥有两种配置。ATS-M能够通过单一解决方案灵活地处理广泛的工作负载,并在不牺牲性能或者质量的同时,优化总体拥有成本。

具体来看,Arctic Sound-M包含两种不同的配置,150W功率版本在一个3/4长、全高尺寸的PCIe 4.0加速卡中封装了32个Xe内核。75W功率版本则在半高尺寸的PCIe 4.0加速卡中封装了两颗具有8个Xe内核的GPU,共16个Xe内核。这两种配置均配备了4个Xe媒体引擎、英特尔首款面向数据中心的AV1硬件编码器和加速器、GDDR 6内存、光线追踪单元和内置XMXAI加速。

不仅如此,ATS-M还为开发者提供了面向流媒体、云游戏和云端推理的开源软件堆栈,并广泛支持AVC、HEVC、VP9,以及更多API、框架和*新的编解码器。

IPU加码未来数据中心

去年6月份,英特尔曾在Six Five峰会上介绍了面向基础设施应用的IPU处理器,旨在使云和通信服务提供商减少在CPU方面的开销,并充分释放性能价值。利用IPU,客户能够部署安全稳定且可编程的解决方案,从而更好地利用资源,平衡数据处理与存储的工作负载。

作为一个可编程的网络设备,IPU能够对数据中心内的基础设施功能进行安全加速,从而使系统级资源的管理更加智能。通过IPU,云运营商可以转向完全虚拟化的存储和网络架构,同时保持超高的性能、以及强大的可预测性与可控性。通过特定功能,IPU可对数据中心中基于微服务架构的现代应用程序进行加速。

而现在英特尔公布了其到2026年的IPU产品路线图,其中包括基于全新FPGA和英特尔架构平台的代号为Hot Springs Canyon的产品,Mount Morga(MMG)ASIC,以及下一代800GB产品。IPU是具有强化加速功能的专用产品,旨在满足基础设施计算需求,使企业能够高效处理任务和解决问题。

AI战略上的又一次跃进

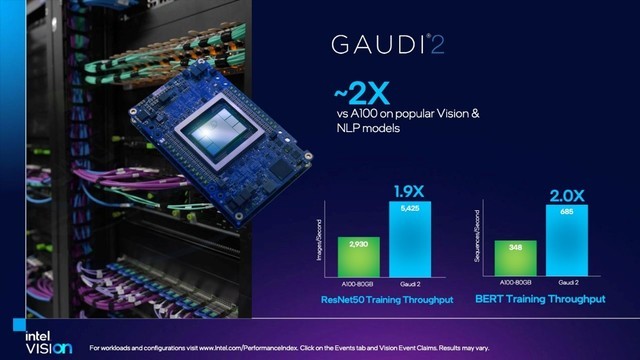

对于数据中心而言,由于数据集和人工智能业务的规模和复杂性日益增长,训练深度学习模型所需的时间和成本越来越高,根据IDC的数据,在2020年接受调查的机器学习从业者中,有74%的人对其模型进行过5-10次迭代训练,超过50%需要每周或更频繁地重建模型,26%的人则每天甚至每小时会重建模型。56%的受访者认为培训成本是阻碍其组织利用人工智能解决问题,创新和增强终端客户体验的首要因素。基于此,英特尔旗下的Habana Labs也在峰会当天发布了用于深度学习训练的第二代Gaudi处理器Gaudi 2,以及即将上市的用于深度学习推理的Goya处理器的后续产品Greco。它们采用了7纳米制程工艺,并以Habana的高能效架构为基础,面向数据中心的计算机视觉和自然语言应用,旨在为客户的模型训练和推理提供更高的性能。

基于与**代Gaudi相同的体系架构,Habana Gaudi 2处理器大幅提高了训练性能。客户在云端运行Amazon EC2 DL1实例以及本地运行Supermicro Gaudi训练服务器时,其性价比比现有GPU解决方案提升了40%,这些都来自于Gaudi2在架构上的进步:包括制程工艺从16纳米跃升至7纳米;在矩阵乘法(MME)和Tensor处理器核心计算引擎中引入了FP8在内的新数据类型;Tensor处理器的核心数量由8个增至24个;芯片上集成多媒体处理引擎,实现从主机子系统的卸载;片内封装的内存容量提升了3倍,从32GB提升到带宽2.45TB/秒的96GB HBM2E;两倍48MB的板载SRAM存储器以及基于RDMA (RoCE2) 的集成以太网从10个增至24个,在标准网络上实现高效的纵向和横向扩展。

这些使得Habana Gaudi 2处理器在与处于相同制程工艺节点的A100 GPU相比时,训练性能高出约两倍,峰会当天,英特尔展示了Gaudi2在RestNet 50 Training Throughput和BERT Tralning Throughput等视频及自然语言处理的模型测试中的测试结果,性能领先十分明显。

算力天花板,Ponte Vecchio让E级计算成为可能

高性能计算是没有边界的,算力的天花板到底是什么程度我们也无从知晓,但人类的探索永无止境,在英特尔On产业峰会上,英特尔也给出了自己的“预判”:E级计算。在峰会当天的开幕主题演讲中,阿贡国家实验室的计算、环境和生命科学实验室主任Rick Stevens,首次展示了极光(Aurora)超级计算机的安装情况,并深入解析它将如何助力解决人类面临的疑难问题,如更准确地预测气候以及发现应对癌症的新疗法,同时让百亿亿次计算(E级)广泛应用于研发和创新活动,这其中,Sapphire Rapids至强处理器和Ponte Vecchio数据中心显卡无疑是重要的算力保障。

作为英特尔迄今为止*复杂的SoC,Ponte Vecchio包含了多达1000亿个晶体管,提供领先的浮点运算和计算密度,以加速AI、HPC和高级分析工作负载。且复杂设计均被集成于Foveros封装中,为提高功率和互连密度形成有源芯片的3D堆叠。高速MDFI互连允许1到2个堆栈的扩展,其中计算单元是一个密集的多个Xe内核,是Ponte Vecchio的核心,一块单元有8个Xe内核,总共有4MB的一级缓存,是提供高效计算的关键,而基础单元是Ponte Vecchio的连接组织,Xe链路单元则提供了GPU之间的连接。

软件力量直面AI挑战

为了在公有云中训练自有神经网络的过程保持工作负载的机密性,博世携手英特尔在一个研究项目中打造了一个机密AI解决方案。为进一步大规模应用此方案,博世企业研究部开发了一个机密AI平台级框架。该框架使用了第三代英特尔至强可扩展平台上搭载的英特尔软件防护扩展(SGX)技术。

SGX本质上是一种基于硬件的可信执行环境,其*大好处在于允许应用程序和CPU进行交互,同时建立一个安全的内存区域,这些安全区域绕过了操作系统和程序管理层,允许在不暴露任何基础设施平台的情况下对机密信息进行操作。即便这个实际的平台软件组件甚至是硬件组织遭到入侵,依然可以保护该区域内的信息。

与常规的隐私保护或者安全技术相比,SGX在安全性、性能和可用性方面都有明显优势。在安全性方面,它是一个硬件级的安全技术,基于对CPU的信任,可以有效避免以往依赖高权限软件而带来的安全隐患;性能方面,在第三代至强可扩展处理器平台上,SGX的计算性能优异,可以有效控制成本;可用性方面,SGX的生态利用LibOS(库操作系统),致力于避免打破现有的应用方式,可以很大程度上降低重新构建一些通信或者是底层架构的代价,从而使数据和模型的加载和保护更加便捷。*大限度上帮助程序开发者把整个数据应用进行无缝迁移。

除了机密计算之外,英特尔也携手埃森哲启动“阿波罗计划”,旨在通过为企业提供经过优化设计的愈30种开源AI解决方案,让其能够在本地、云端亦或是边缘环境中都更易于部署AI。

纵观整个行业,算力提升的需求正驱动着数据中心的基础架构转型,这个转型不仅包括硬件层面,更包括软件层面。现在来看,英特尔正在通过整合技术和生态系统,面向目前以及未来,让千行百业的客户得以释放更多数据价值。