产品详情

DGX A100

加速当今时代的重要工作

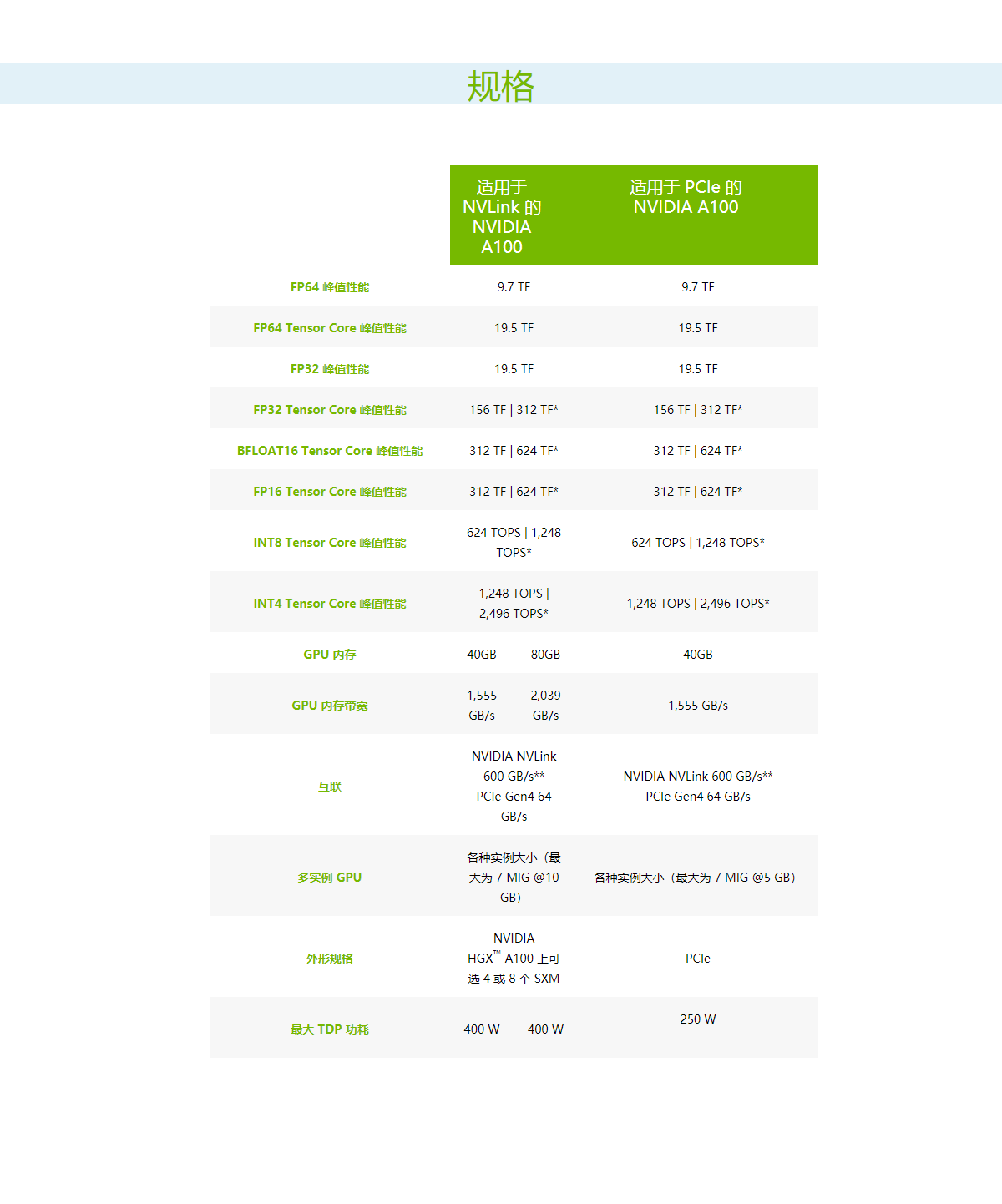

NVIDIA A100 Tensor Core GPU 可针对 AI、数据分析和 HPC 应用场景,在不同规模下实现出色的加速,有效助力全球高性能弹性数据中心。NVIDIA A100 由 NVIDIA Ampere 架构提供支持,提供 40GB 和 80GB 两种配置。作为 NVIDIA 数据中心平台的引擎,A100 的性能比上一代产品提升高达 20 倍,并可划分为七个 GPU 实例,以根据变化的需求进行动态调整。A100 80GB 将 GPU 内存增加了一倍,提供超快速的内存带宽(每秒超过 2TB),可处理超大模型和非常庞大的数据集。

产品特性

深度学习训练

当今的 AI 模型面临着对话式 AI 等更高层次的挑战,这促使其复杂度呈爆炸式增长。训练这些模型需要大

规模的计算能力和可扩展性。

NVIDIA A100 的 Tensor Core 借助 Tensor 浮点运算 (TF32) 精度,可提供比上一代 NVIDIA Volta 高 20 倍之多的性能,并且无需更改代码;若使用自动混合精度和 FP16,性能可进一步提升 2 倍。与 NVIDIA® NVLink®、NVIDIA NVSwitch™、PCI 4.0、NVIDIA® Mellanox® InfiniBand® 和 NVIDIA Magnum IO™ SDK 结合使用时,可扩展到数千个 A100 GPU。

2048 个 A100 GPU 可在一分钟内大规模处理 BERT 之类的训练工作负载,这是训练时间的世界纪录。

对于具有庞大数据表的超大型模型(例如用于推荐系统的 DLRM),A100 80GB 可为每个节点提供高达 1.3 TB 的统一显存,而且速度比 A100 40GB 快高达 3 倍。

NVIDIA 产品的领先地位在 MLPerf 这个行业级 AI 训练基准测试中得到印证,创下多项性能纪录。

在大型模型上将 AI 训练的速度提升高达 3 倍

DLRM 训练

深度学习推理

A100 引入了突破性的功能来优化推理工作负载。它能在从 FP32 到 INT4 的整个精度范围内进行加速。多实例 GPU (MIG) 技术允许多个网络同时基于单个 A100 运行,从而优化计算资源的利用率。在 A100 其他推理性能增益的基础之上,仅结构化稀疏支持一项就能带来高达两倍的性能提升。

在 BERT 等先进的对话式 AI 模型上,A100 可将推理吞吐量提升到高达 CPU 的 249 倍。

在受到批量大小限制的极复杂模型(例如用于先进自动语音识别用途的 RNN-T)上,显存容量有所增加的 A100 80GB 能使每个 MIG 的大小增加一倍(达到 10GB),并提供比 A100 40GB 高 1.2 倍的吞吐量。

NVIDIA 产品的出色性能在 MLPerf 推理测试中得到验证。A100 再将性能提升了 20 倍,进一步扩大了这种性能优势。

与 CPU相比,AI推理性能提高达249倍

BERT-Large 推理

与 A100 40GB 相比,AI 推理性能提升 1.25 倍

RNN-T 推理:单流

产品参数

资源下载

NVIDIA DGX A100 白皮书

下载